L’époque où les élèves dessinaient des oreilles de lapin à leur professeur de sciences ou à leur ami est révolue.

C’était il y a une trentaine d’années. Aujourd’hui, les écoles sont contraintes d’élaborer des plans d’intervention d’urgence au cas où des images sexuellement explicites d’élèves ou d’enseignants générées par l’intelligence artificielle (IA) apparaîtraient sur les médias sociaux.

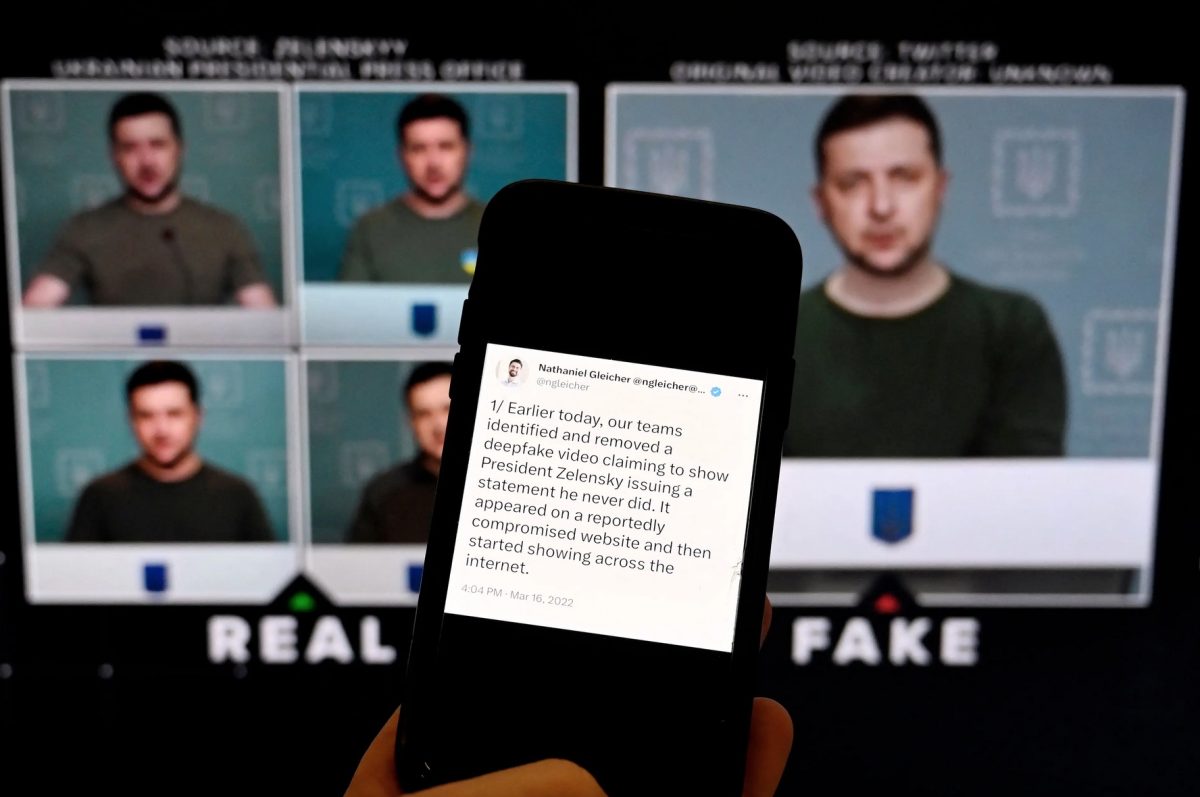

Dans deux cas distincts, des directeurs d’école ont été vus ou entendus en train de proférer des propos racistes et violents à l’encontre d’élèves noirs. Il s’agissait dans les deux cas de deepfakes générés par l’IA – l’un a été produit par des élèves et l’autre par un directeur sportif mécontent qui a été arrêté par la suite.

Les « deepfakes » sont définis comme « des voix, des images ou des vidéos générées par l’IA de manière non consenties et créées pour produire des images sexuelles, commettre des fraudes ou diffuser des informations erronées », selon une ONG qui se consacre à la réglementation de l’IA.

Alors que les responsables de l’éducation s’efforcent de définir des politiques pour atténuer les dommages causés par les « deepfakes » et que les législateurs des États s’efforcent de criminaliser ces actes malveillants spécifiques aux écoles ou aux enfants, la technologie permettant de lutter contre les outils d’IA capables de reproduire l’image et la voix d’une personne n’existe pas encore, affirme Andrew Buher, fondateur et directeur général de l’organisation de recherche à but non lucratif Opportunity Labs.

« Il y a beaucoup de travail à faire, tant au niveau de la prévention que de la réponse aux incidents », a-t-il déclaré lors d’une table ronde virtuelle organisée par Education Week le mois dernier sur l’enseignement des compétences numériques et médiatiques à l’ère de l’IA. « Il s’agit d’une question de normalisation sociale [car] l’atténuation technique est encore loin. »

La législation s’attaque aux « deepfakes »

Le 29 septembre, le gouverneur de Californie, Gavin Newsom, a promulgué une loi criminalisant la pornographie enfantine générée par l’IA. La possession, la publication ou la transmission d’images de personnes âgées de moins de 18 ans simulant un comportement sexuel constituent désormais un délit.

De nouvelles lois similaires ont été adoptées à New York, dans l’Illinois et dans l’État de Washington.

Au niveau national, le sénateur du Texas Ted Cruz a proposé la loi « Take It Down Act » (Loi sur le démantèlement, ndlr), qui criminaliserait la « divulgation intentionnelle de représentations visuelles intimes non consenties ».

Le projet de loi fédéral définit un deepfake comme « une vidéo ou une image générée ou substantiellement modifiée à l’aide de techniques d’apprentissage automatique ou de tout autre moyen généré par ordinateur ou par machine pour représenter faussement l’apparence ou le comportement d’un individu dans une représentation visuelle intime ».

Les districts scolaires, quant à eux, cherchent des conseils sur un problème émergeant qui menace non seulement les élèves, mais aussi le personnel.

En janvier, au lycée de Pikesville, dans le Maryland, un faux enregistrement audio a été réalisé sur le proviseur. Les responsables de l’établissement ont demandé l’aide de la police locale et du FBI.

Le suspect, Dazhon Darien, 31 ans, directeur sportif, a été inculpé de vol, de harcèlement, de perturbation du fonctionnement de l’école et de représailles contre un témoin.

Selon un communiqué de presse publié le 25 avril sur le site Web du gouvernement du comté de Baltimore, il aurait réalisé l’enregistrement pour se venger du directeur de l’école, qui enquêtait sur la mauvaise gestion présumée des fonds de l’école par Darien.

Jim Siegl, expert en technologie auprès du Future of Privacy Forum, a déclaré que les enquêteurs de l’affaire de Baltimore ont pu établir un lien entre le suspect et le crime en examinant les « anciens registres d’accès aux ordinateurs ».

Mais comme la technologie de l’IA continue d’évoluer, il pourrait être nécessaire de développer un système de filigrane pour les fichiers audio ou vidéo générés afin de remplacer les systèmes obsolètes de surveillance et de protection de l’utilisation des ordinateurs à l’école.

En février 2023, des lycéens de Carmel, dans l’État de New York, ont utilisé l’IA pour se faire passer pour le principal d’un collège. Les deepfakes ont été postés sur TikTok. Les enquêteurs ont pu relier les activités des élèves à leurs comptes. Ils ont été sanctionnés en vertu du code de conduite de l’école, mais n’ont pas fait l’objet de poursuites pénales.

« En tant qu’organisation engagée en faveur de la diversité et de l’inclusion, le conseil d’éducation du district scolaire central de Carmel est consterné par ces récentes vidéos et les condamne, ainsi que le racisme flagrant, la haine et le mépris de l’humanité affichés dans certaines d’entre elles », indique le communiqué.

Un parent, Abigail Lyons, a déclaré qu’un collègue qui a également des enfants dans le district lui a montré un message contenant sept vidéos différentes.

« Je suis tombée de ma chaise », a déclaré Abigail Lyons – qui est métisse. « C’était horrible. Cela avait l’air si réel. »

Ils ont revu les vidéos et ont remarqué que le mouvement des lèvres et le langage corporel étaient un peu en décalage avec le son. Selon Mme Lyons, la plupart des parents du district avaient déjà vu ou entendu parler des vidéos et savaient probablement qu’il s’agissait de fausses vidéos avant que les responsables de l’école de Carmel ne reconnaissent publiquement l’incident et déclarent qu’il n’y avait « pas de menace ».

Mme Lyons a déclaré que la situation avait effrayé sa fille et que des événements tels que les fermetures d’écoles ou les exercices d’urgence suscitaient encore de l’anxiété et de la peur en raison de la fausse alerte de 2023.

« Les élèves de septième année ne devraient pas avoir à s’inquiéter de ces choses », a-t-elle déclaré à Epoch Times.

Mme Lyons a déclaré qu’elle n’avait connaissance d’aucun incident lié au deepfake depuis le début du semestre, mais que des élèves s’étaient menacés les uns les autres sur les réseaux sociaux, dont une menace qui a entraîné le confinement du bâtiment pendant deux heures.

« Nous ne savons toujours pas à quoi elle [la fermeture] a servi », a-t-elle déclaré. « La transparence n’est toujours pas au rendez-vous. »

Epoch Times a contacté les bureaux des districts de Carmel (New York) et du comté de Baltimore (Maryland), mais n’a pas reçu de réponse.

La nouvelle loi californienne a été adoptée à la suite de plusieurs incidents de deepfake qui ont fait des victimes parmi les élèves.

Patrick Gittisriboongul, surintendant adjoint chargé des technologies et de l’innovation au Lynwood Unified School District, près de Los Angeles, a déclaré que son district avait mis en œuvre une politique de tolérance zéro qui oblige le personnel à avertir les forces de l’ordre, à fournir des services aux victimes et à déployer un plan d’intervention en cas d’incident lié à l’IA.

Le district restreint l’utilisation de l’IA, utilise des filtres de contenu pour les activités en ligne et exige des élèves et du personnel qu’ils respectent les directives relatives à l’utilisation éthique de la technologie.

« Les incidents survenus dans d’autres districts du sud de la Californie nous ont incités à prendre des mesures proactives », a-t-il déclaré par courriel à Epoch Times. « Compte tenu de l’émergence rapide de l’IA et de son utilisation abusive potentielle, nous avons rédigé une politique globale pour nous assurer que notre district est prêt à faire face à tout problème futur impliquant des deep fakes ou des contenus inappropriés générés par l’IA. »

Le mois dernier, le Center for Democracy and Technology a rapporté que 40 % des élèves et 29 % des enseignants avaient connaissance de deepfakes représentant des enfants ou des adultes associés à leur école au cours de l’année scolaire 2023-2024.

Le rapport se fonde sur une enquête menée auprès d’environ 3300 personnes dans tout le pays, représentant les classes du collège au lycée, et comprenant des parents et des enseignants. 38 % des personnes interrogées ont jugé le contenu du deepfake choquant, et 33 % l’ont décrit comme sexuellement explicite.

Selon le rapport, la plupart des enseignants ont déclaré qu’ils n’avaient pas reçu de formation sur la manière de réagir aux « deepfakes » et que leurs districts n’avaient pas mis à jour leurs politiques pour faire face à ce type d’incidents.

Le rapport indique également que la plupart des enseignants interrogés ont indiqué que leurs employeurs n’avaient pris que peu de mesures pour faire face à la menace des deepfakes. Moins d’un quart des personnes interrogées ont déclaré que le terme « deepfake » avait été ajouté à la politique du district en matière de harcèlement sexuel ou au code de conduite des élèves.

Les enseignants préfèrent contacter les forces de l’ordre pour sanctionner les auteurs de deepfakes, la suspension à long terme étant le deuxième choix et le soutien psychologique le troisième, selon le rapport.

En revanche, les parents n’ont inclus aucune de ces mesures dans leurs trois premiers choix. Ils préfèrent éduquer les primo-délinquants sur les effets néfastes des deepfakes, selon le rapport. Leur deuxième choix est le soutien psychologique, et leur troisième choix est l’émission d’un avertissement.

Réglementation de l’IA

Un consortium d’organisations à but non lucratif, dont la National Organization for Women, le Future of Life Institute et le Center for Human-Compatible Artificial Intelligence, a lancé au début de l’année la Campaign to Ban Deepfakes (CBD), une campagne mondiale de sensibilisation du public pour bannir les deepfakes.

La CBD fait circuler une pétition en ligne pour soutenir son appel à la criminalisation de tous les deepfakes et à la responsabilisation des développeurs de technologies et des créateurs de contenu.

« Le seul moyen efficace de mettre fin aux deepfakes est que les gouvernements les interdisent à chaque étape de la production et de la distribution », déclare le CBD sur son site web. Le site note que le contenu sexuel des deepfakes a augmenté de 400 % et la fraude liée aux deepfakes de 300 % entre 2022 et 2023.

« Il n’existe aucune loi ciblant et limitant efficacement la création et la circulation des deepfakes, et toutes les exigences actuelles imposées aux créateurs sont inefficaces », a déclaré le CBD.

Demander des conseils juridiques

Il existe de nombreux conseils juridiques gratuits en ligne que les établissements scolaires peuvent utiliser pour faire face aux menaces.

Un cabinet californien spécialisé dans le droit de l’éducation – Atkinson, Andelson, Loya, Ruud & Romo (AALRR) – a publié des conseils sur les deepfakes avant l’année scolaire 2024-25, citant les incidents de Carmel et du comté de Baltimore, ainsi qu’un incident dans l’État de Washington.

Dans ce dernier cas, les responsables du district ont déclaré qu’ils n’avaient pas appelé la police après qu’une étudiante a été victime d’agression parce que leurs avocats leur avaient dit qu’ils n’étaient pas tenus de signaler les images « truquées ».

Les avocats d’AALRR ont refusé d’accorder une interview à Epoch Times, mais le site web de l’entreprise indique que les districts peuvent être poursuivis en justice pour ne pas avoir réagi de manière appropriée aux deepfakes en vertu de lois antérieures à l’IA. Ils conseillent aux chefs d’établissement d’établir des politiques en matière d’IA et d’éduquer les élèves sur la manière dont l’IA peut être utilisée de manière responsable ou à mauvais escient.

La tâche la plus difficile est de comprendre et de traiter les actions qui se déroulent en dehors de l’enceinte de l’école mais qui ont un impact sur les communautés scolaires de la maternelle à la terminale. Les limites entre les responsabilités des parents et celles de l’école ne sont pas toujours claires.

« L’utilisation abusive par les étudiants du contenu généré par l’IA soulève probablement des problèmes similaires en ce qui concerne le premier amendement », note le site web de l’AALR. « Une école cherchant à punir un étudiant pour une utilisation abusive de l’IA en dehors du campus devrait démontrer que l’utilisation abusive de l’IA par l’étudiant a eu un impact substantiel sur l’école. »

Alors que les agences tentent de cimenter une norme sociale dans le monde entier, des millions d’élèves et d’employés d’établissements scolaires restent vulnérables.

Les responsables de l’éducation devraient s’efforcer de sensibiliser aux préjudices et aux conséquences des usurpations d’identité générées par l’IA et faire comprendre aux communautés scolaires que l’utilisation de cette technologie émergente pour porter atteinte à la réputation d’une autre personne est une forme de harcèlement, a déclaré M. Siegl.

« Laissons les forces de l’ordre déterminer s’il s’agit d’un deepfake ou non », a-t-il ajouté.

Comment pouvez-vous nous aider à vous tenir informés ?

Epoch Times est un média libre et indépendant, ne recevant aucune aide publique et n’appartenant à aucun parti politique ou groupe financier. Depuis notre création, nous faisons face à des attaques déloyales pour faire taire nos informations portant notamment sur les questions de droits de l'homme en Chine. C'est pourquoi, nous comptons sur votre soutien pour défendre notre journalisme indépendant et pour continuer, grâce à vous, à faire connaître la vérité.