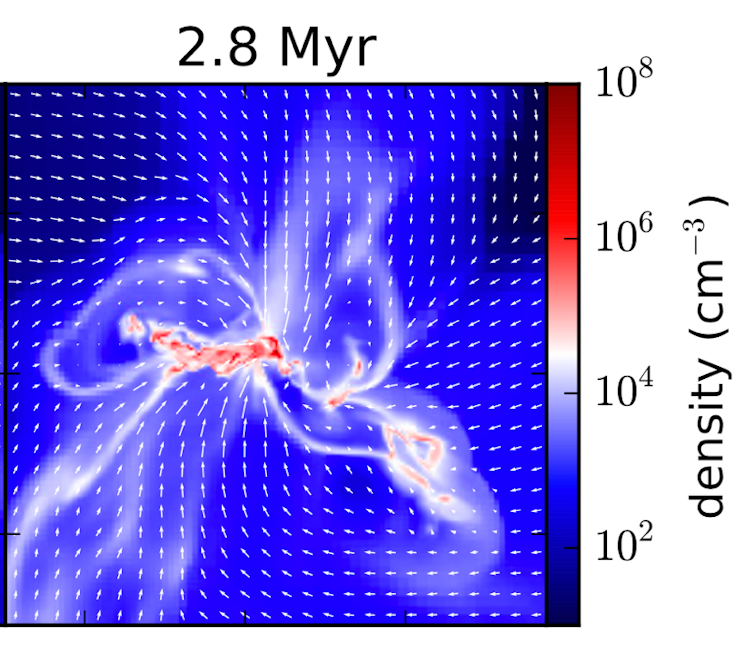

Afin de comprendre les objets célestes composant l’Univers, les astrophysiciens développent des simulations numériques tridimensionnelles et dépendantes du temps. Elles génèrent une quantité sans cesse croissante de données, qu’il faut efficacement analyser afin de lever les nombreux voiles entourant les mystères de notre Univers.

L’Univers est composé d’une multitude d’objets (planètes, étoiles, milieu interstellaire, galaxies…) au comportement dynamique souvent non linéaire, associé à une large gamme d’échelles spatiales, énergétiques et temporelles. La simulation numérique haute performance (HPC) est un outil idéal pour comprendre leur fonctionnement, en résolvant par approximations numériques les équations complexes de la dynamique des plasmas couplées à des processus tels que la compressibilité, le magnétisme, le rayonnement, la gravitation…

Cela nécessite d’utiliser des calculateurs extrêmement puissants (les supercalculateurs). Aujourd’hui, les plus performants sont capables de réaliser plusieurs millions de milliards d’opérations à la seconde (petaflop/s). À l’horizon 2020, ils pourront en réaliser un milliard de milliards à la seconde : c’est l’exaflop/s. D’où le terme de HPC (pour High Performance Computing ou calcul haute performance) qui désigne, également, par extension, la science développée autour de ces équipements (matériels, logiciels, etc.).

Vastes jeux de données

Pour améliorer le réalisme de ces simulations, de plus en plus de résolutions spatiales ou spectrales (en énergie ou longueur d’onde) et de processus physiques doivent être pris simultanément en compte, générant de vastes jeux de données à explorer et analyser. Ainsi, la discrétisation (découpage en petites cellules du domaine de calcul) spatiale des objets simulés nécessite de plus en plus de cellules pour reproduire la réalité, les calculs les plus ambitieux sur les calculateurs pétaflopiques actuels atteignant jusqu’à 64 milliards de cellules.

Chaque cellule suit au cours du temps plusieurs champs ou variables physiques (leur nombre augmentant d’autant plus qu’il y a de contenu physique) représentés par des nombres réels dits « double précision » (stockés sur 8 octets). Plusieurs milliers de pas de temps sont nécessaires pour former des moyennes temporelles statistiquement significatives. On voit très vite l’ampleur de la tâche s’il faut multiplier cette volumétrie pour parcourir l’espace des paramètres, d’autant que l’exaflop permettra demain d’exécuter des simulations comportant plus de mille milliards de cellules !

Pour exploiter au mieux les données produites, précisons que corrélation n’est pas raison. En astrophysique, si un lien physique clair n’est pas établi entre les variables, une corrélation n’a que très peu d’intérêt et la dynamique des corps célestes ne peut être reconstruite par des processus de data mining traditionnels.

Pour pallier cette difficulté, la communauté internationale développe des bases de données ouvertes (Open Data) favorisant leur analyse grâce à des interfaces augmentées et leur réutilisation par le plus grand nombre. Le CEA a lancé une telle base de données dédiée aux simulations astrophysiques, dans le cadre du projet COAST (COmputational ASTrophysics at Saclay).

Cet article est publié en partenariat avec le CEA dans le cadre de la nouvelle formule du magazine Clefs dont le premier numéro a été consacré au big data.

Allan Sacha Brun, Astrophysicien, chef du Laboratoire dynamique des étoiles, des exoplanètes et de leur environnement, Commissariat à l’énergie atomique (CEA) – Université Paris-Saclay; Damien Chapon, Ingénieur au Laboratoire d’ingénierie logicielle pour les applications scientifiques, Commissariat à l’énergie atomique (CEA) – Université Paris-Saclay et Patrick Hennebelle, Astrophysicien au Laboratoire de Modélisation des Plasmas Astrophysiques, Commissariat à l’énergie atomique (CEA) – Université Paris-Saclay

La version originale de cet article a été publiée sur The Conversation.

Comment pouvez-vous nous aider à vous tenir informés ?

Epoch Times est un média libre et indépendant, ne recevant aucune aide publique et n’appartenant à aucun parti politique ou groupe financier. Depuis notre création, nous faisons face à des attaques déloyales pour faire taire nos informations portant notamment sur les questions de droits de l'homme en Chine. C'est pourquoi, nous comptons sur votre soutien pour défendre notre journalisme indépendant et pour continuer, grâce à vous, à faire connaître la vérité.